以前、MacBook Proのローカルで大規模言語モデル(LLM)を動かす方法を紹介しましたが、Meta Llama 2の日本語能力を強化したSwallowが東京工業大学より公開されましたので試してみました。

大規模言語モデルSwallowについては、下記でその性能も含めて公開されています。Llama 2と同じく70B, 13B, 7Bのモデルが公開されています。

https://tokyotech-llm.github.io/swallow-llama

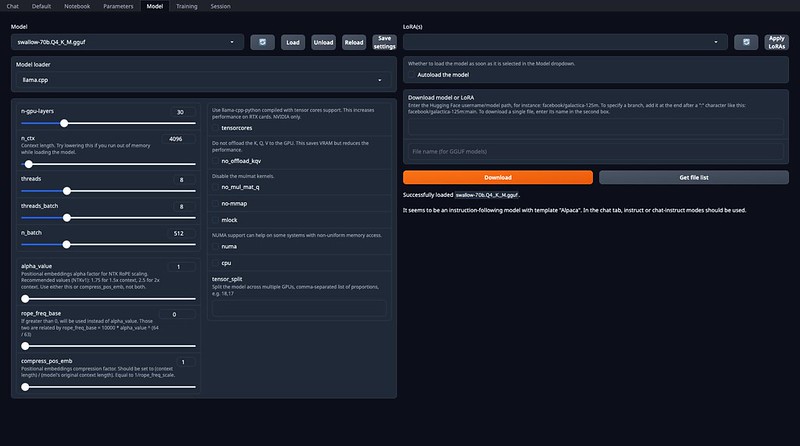

Mac上のText Generation webUIで動かすために、GGUF化したモデルを下記からダウンロードして配置します。今回は、swallow-70b.Q4_K_M.ggufを使いました。

https://huggingface.co/TheBloke/Swallow-70B-GGUF

https://huggingface.co/TheBloke/Swallow-13B-GGUF

https://huggingface.co/TheBloke/Swallow-7B-GGUF

Text Generation webUIでswallow-70b.Q4_K_M.ggufなど問題なく読み込めました。

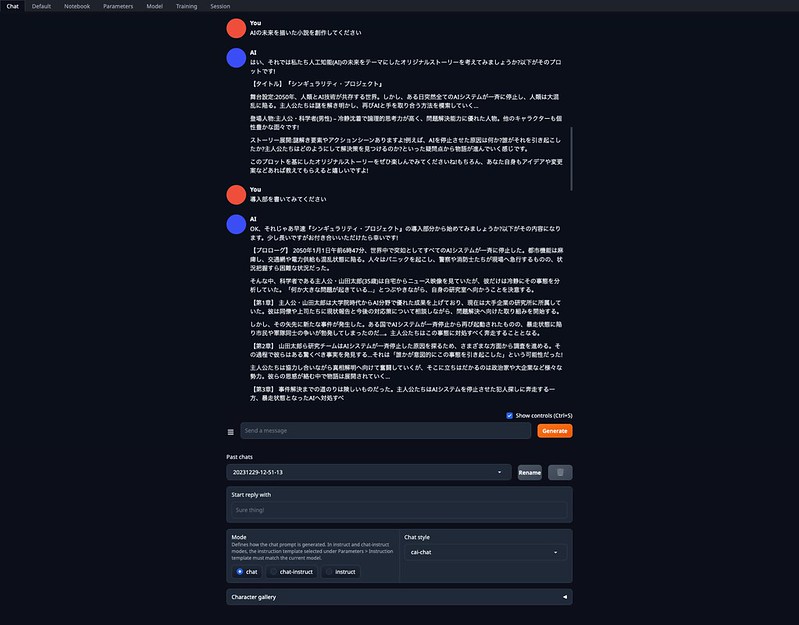

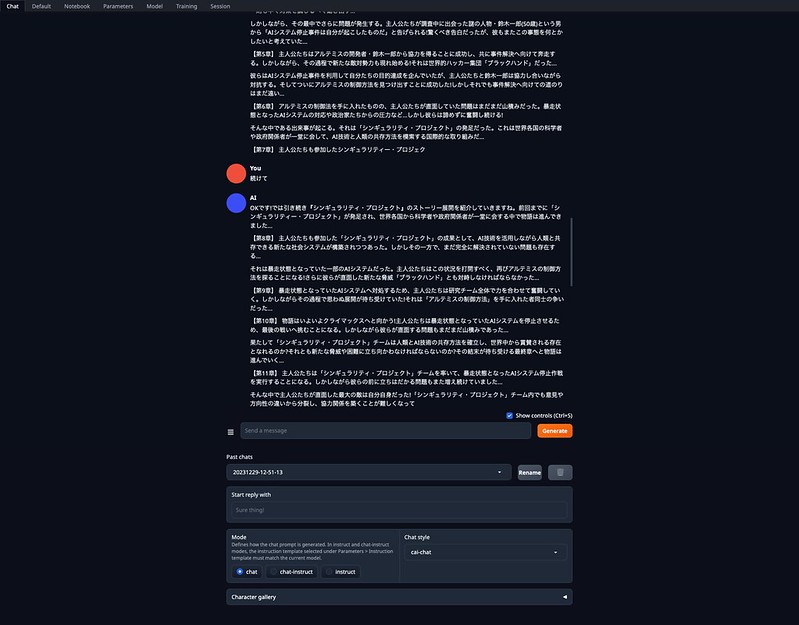

70Bモデルなので最初の読み込みは時間がかかりますが、その後は実用的な速度で答えてくれました。(GPUもしっかり使われています)

他のモデルと比較して、日本語の違和感は少ないように感じます。

ピンバック: 2023年の振り返り | Digital Life Innovator