以前、Stable DiffusionのControlNetを使って、AIモーション模写を試しましたが、同じようなAI動画の作成がより簡単に行えるmov2movという拡張が出たので、試してみました。mov2movはimg2imgの動画版で、やっていることはフレームを切り出して、img2imgを行っている感じですね。ControlNetも進化しているので合わせて紹介します。

コンテンツ目次

ControlNet 1.1

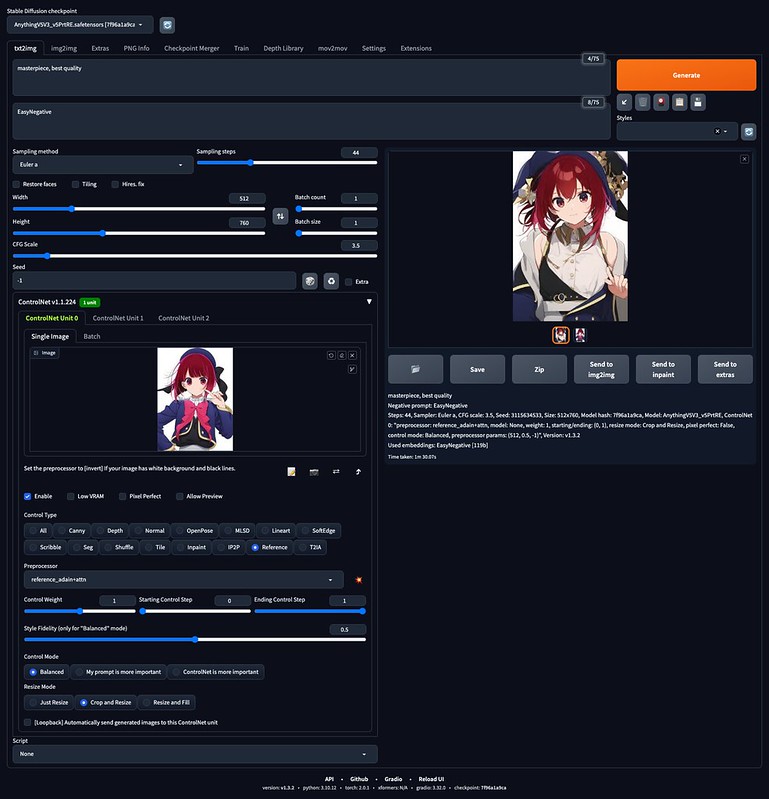

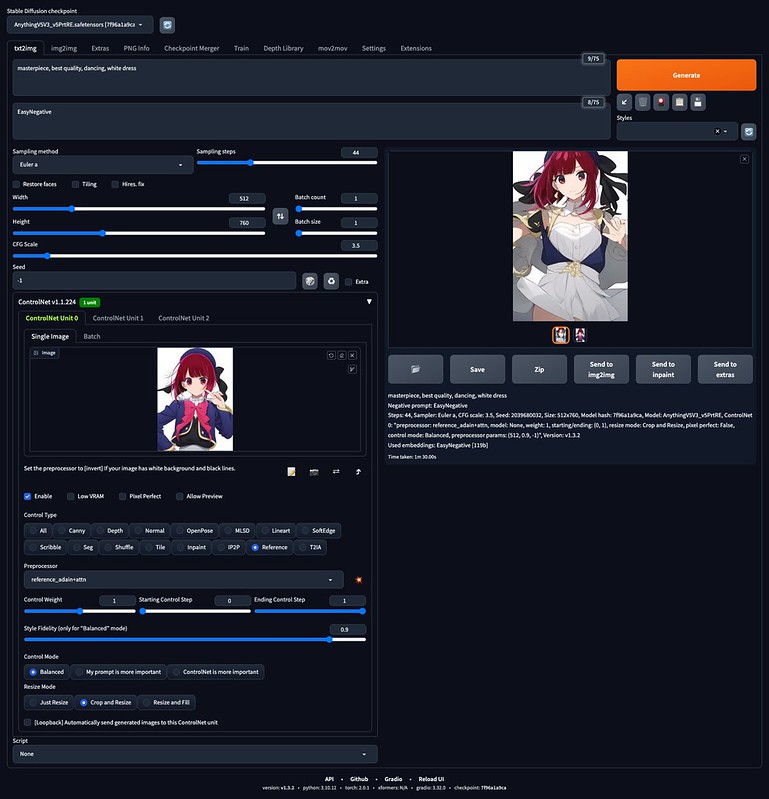

ControlNetにはReferenceという機能が追加されました。Referenceは、入力した画像の画風を反映させる機能です。LoRAのような学習をしなくても1枚の画像を入力するだけで似たような画像を生成してくれるので、同じキャラクターを生成したいときなどに便利です。

Reference-only, Reference-adain, Reference-adain+attnの3つのプリプロセッサがありますが、正直違いは試してみないとよくわかりません。あと、Style Fidelity (only for “Balanced” mode)の数値をいじることで画風を優先するか、プロンプトを優先するかを調整することができます。

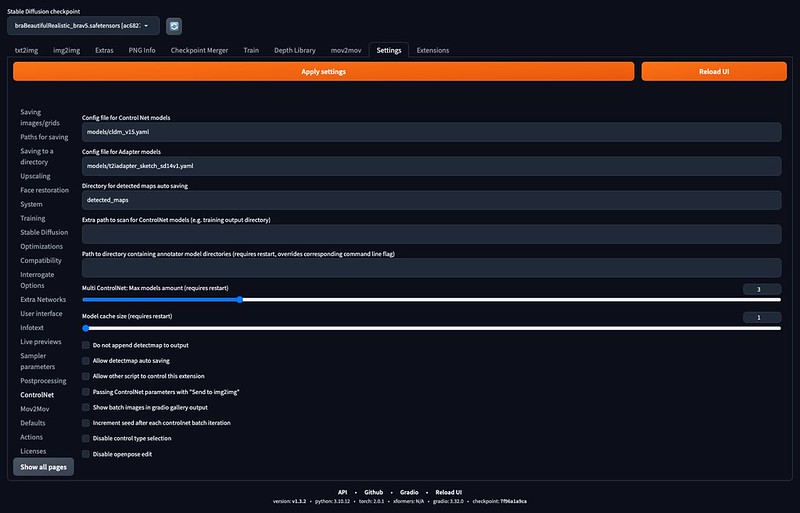

さらにSettingsのControlNetで、Multi ControlNet: Max models amount (requires restart)の値を2以上に設定してApply settings、Reload UIを行うことで、複数のControlNetを適用できるようになります。

mov2mov

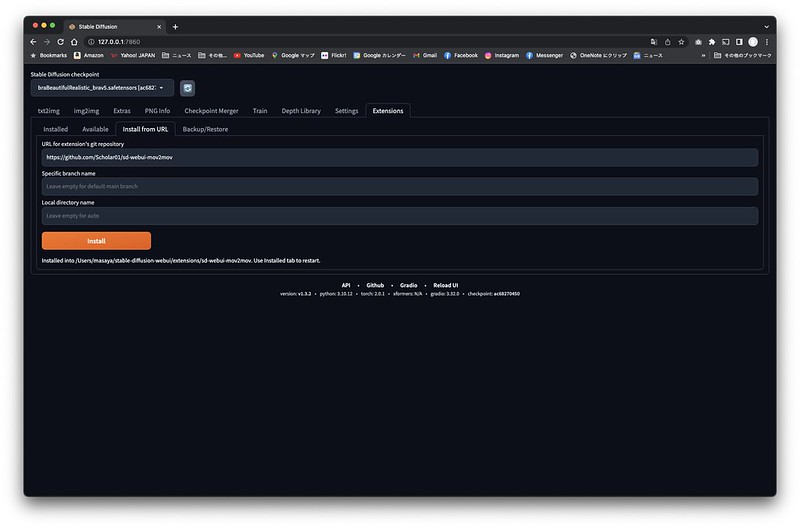

mov2movはExtensionsたぶのInstall from URLに下記URLを入れてインストールし、UIを再起動します。

https://github.com/Scholar01/sd-webui-mov2mov

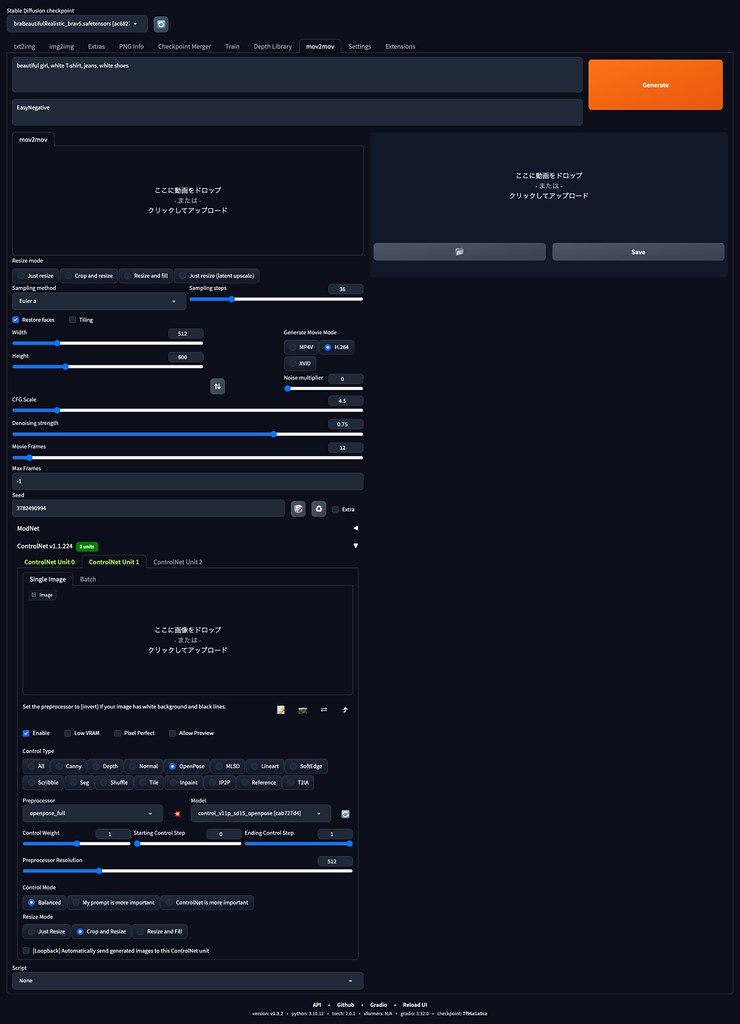

するとmov2movタブが出てきますので、img2imgと同じ感じで利用できます。

違うのは画像のかわりに動画をドロップして、フレーム数や動画形式を設定します。

ControlNet複数利用できるようにして、テイストに一貫性をもたせられるReferenceと動画のポーズを反映できるControlを使うのが良い感じになりました。動画だとかなり時間がかかりますが、全自動で動画までアウトプットしてくれるので、放置しておけばよいのが良いです。

推しの子のサインはBの振り付け動画をmov2movでAI動画に変換してみました。

ControlNet Reference-only + OpenPose 12フレームの例

ControlNet Reference-only + Depth 15フレームの例

Depthの方がより忠実にポーズを再現、OpenPoseはよりキャラが正しい感じになりますね。やはり変なところは多いですが、以前と比べてかなりキャラの一貫性などは上がっていると思います。プロンプトや設定を調整すればもっとうまくできそう。自動でここまでできるのはすごいですね。

ピンバック: Macで #ip-adapter を使って1枚のアニメ画像からAIコスプレ写真を生成する方法 と #AnimateDiff でテキストから短いAI動画を生成する方法 #StableDiffusion | Digital Life Innovator

ピンバック: 2023年の振り返り | Digital Life Innovator